Linux C/C++多进程同时写一个文件(一)

近期会写关于《Linux C/C++多进程同时写一个文件》的系列文章,主要是探索在Linux下非亲缘关系的多进程和具有亲缘关系的多进程同时写一个文件的问题。例如,当两个进程同时写一个文件,那么写入结果是怎样的呢?是否会出现数据丢失的情况?是否会出现覆盖?是否会出现错乱?

本文是这一系列文章的第一篇,通过两个非亲缘关系的进程演示同时写一个文件的情形,最终得出结论、回答上面的问题。

1 查看要写入的文件的inode信息

使用如下命令可以查看要写入的文件LINUX_MUTIL_PROCESS_WRITE对应的inode情况,可以看到它的值为67530247。

[vfhky@typecodes ~]$ stat /home/vfhky/src/linux/process/fork1/LINUX_MUTIL_PROCESS_WRITE

File: ‘/home/vfhky/src/linux/process/fork1/LINUX_MUTIL_PROCESS_WRITE’

Size: 1220608 Blocks: 2384 IO Block: 4096 regular file

Device: 803h/2051d Inode: 67530247 Links: 1

Access: (0664/-rw-rw-r--) Uid: ( 1000/ vfhky) Gid: ( 1000/ vfhky)

Access: 2017-10-28 12:00:32.935269018 +0800

Modify: 2017-10-28 12:02:32.228412041 +0800

Change: 2017-10-28 12:02:32.228412041 +0800

Birth: -

[vfhky@typecodes ~]$

2 示例程序

下面这个linux_process_fork1_5.c程序很简单,主要是把p_buf指向的静态区数据写入到文件LINUX_MUTIL_PROCESS_WRITE中。

为了测试多进程同时写文件的情景,需要复制linux_process_fork1_5.c程序为linux_process_fork1_6.c,同时把p_buf指向改成abcdefghi,然后分别编译成两个不同的可执行文件:linux_process_fork1_5 和 linux_process_fork1_6。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 | |

3 开始测试

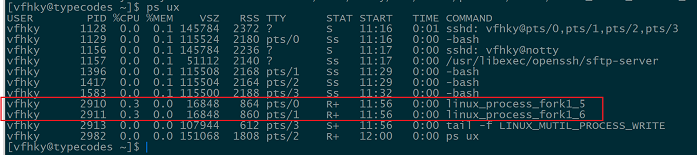

打开两个linux ssh终端,然后分别执行linux_process_fork1_5(对应进程pid为2910)、linux_process_fork1_6(对应进程pid为2910)。

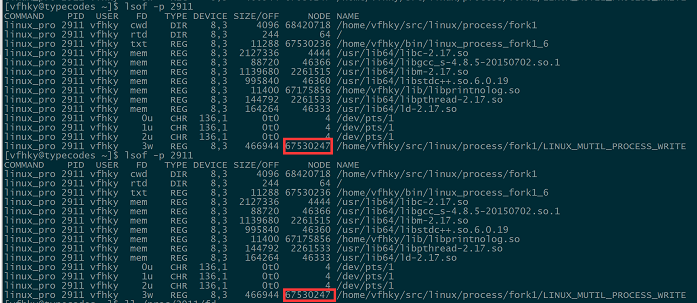

再打开一个ssh终端,使用lsof -p 2910命令查看两个进程打开的文件情况,从下图中可以看出这两个进程开打的都是同一个文件(对应的inode值为67530247)。

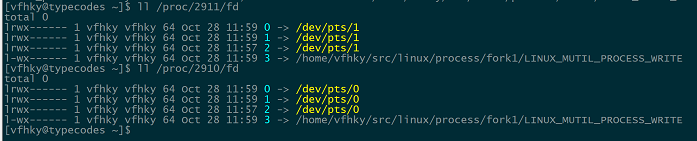

使用ll /proc/2910/fd命令查看两个进程表项中的所有文件描述符,都是标准输入0、标准输出1、标准错误输出2和打开的文件对应的描述符3。也就是说对于文件描述符3来说,这两个进程表项指向的文件表项中的v节点指针指向的是同一个v节点(包含i节点、文件长度等信息,且唯一)。

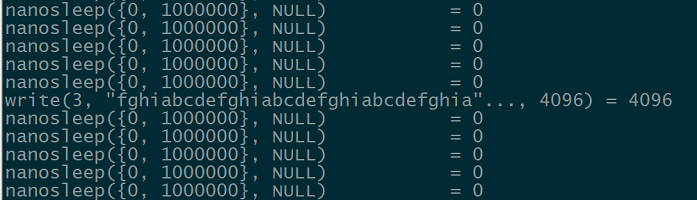

使用strace -p 2910命令查看两个进程的内核调用情况,可以看到这两个进程由于for循环的缘故,一直在调用usleep和fwrite函数,而这两个函数最终会调用内核的nanosleep和write函数。

需要思考一点,为什么会函数write(3, "fghiabcdefghiabcdefghiabcdefghia"..., 4096) = 4096第2个参数不是程序中指定的abcdefghi而是4096个字节的字符。从这里可以延伸到write和fwrite的区别,就不多说了。

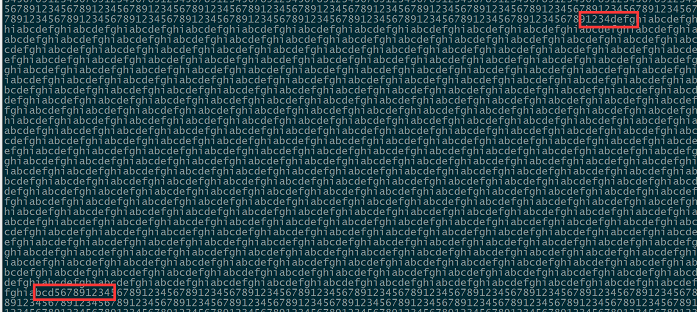

最后通过tail -f LINUX_MUTIL_PROCESS_WRITE命令查看文件写入情况,从下图两个红色标注可以看出linux_process_fork1_5进程写入的123456789在字符4后插入了linux_process_fork1_6进程写入的defg等数据。

4 结论

从上面小节的测试过程可以发现,两个非亲缘关系的进程同时写一个文件时,会出现数据混乱的情况,但是两个进程写入的数据没有覆盖。

这是因为这两个进程表项中指向的对应的两个文件表项对应的当前文件偏移量是不一致的,但是由于打开文件时是使用append追加的方式,使得进程指向的文件表项中的当前文件偏移量都等于当前文件中所有数据的总长度。这就是为什么写入的数据会出现错乱,但是不会出现覆盖(偏移量不一致)的原因。

注意:内核write函数在写入时是原子操作,所以两个进程会有一个竞争关系,最终只会由某个进程写入数据。

5 附录

关于Linux C/C++多个亲缘关系的进程同时写同一个文件的分析请参考下一篇文章。

Comments »